AI가 우리 모두를 죽일 것인가? 나도 모르고 당신도 모릅니다.

하지만 제프 힌튼(Geoff Hinton)은 걱정하기 시작했고 나도 마찬가지다. 나는 지난주에 힌튼의 우려를 소문으로 들었고, 그는 어제 이를 공개적으로 인정했다.

그의 우려를 증폭시켜서 나는 사고 실험을 했습니다.

✔️ 자세히 알아보기 URL (More information) ↓https://twitter.com/garymarcus/status/1640324679968903177?s=61&t=2voLMkhJf6P349CqztWSAQ

곧 수백 명의 사람들, 심지어 엘론 머스크(Elon Musk)도 이에 동참했습니다.Soon, hundreds of people, even Elon Musk, chimed in.

✔️ 자세히 알아보기 URL (More information) ↓https://twitter.com/elonmusk/status/1640483768002662402?s=61&t=2voLMkhJf6P349CqztWSAQ

Hinton, Musk, 그리고 제가 부분적으로 동의하는 경우도 흔하지 않습니다. 머스크와 저는 또한 이번 주 초 미래 생명 연구소(FLI)의 우려 서한에 서명했습니다. 이는 이론적으로는 내일까지 금지되어 있지만 쉽게 찾을 수 있습니다.It’s not often that Hinton, Musk, and I are even in partial agreement. Musk and I also both signed a letter of concern from the Future of Life Institute [FLI], earlier this week, which is theoretically embargoed til tomorrow but is easy enough to find.

§§

푸시백을 받았어요I’ve been getting pushback11그리고 내가 Hinton 트윗을 게시한 이후로 계속 질문을 했습니다. 어떤 사람들은 내가 Hinton 트윗을 잘못 해석했다고 생각했습니다. 다른 사람들은 내가 잘못된 위험에 집중하고 있다고 불평했습니다(단기적으로 너무 많이 또는 장기적으로 너무 많이). and queries ever since I posted the Hinton tweet. Some thought I had misinterpreted the Hinton tweet (given my independent sourcing, I am quite sure I didn’t); others complained that I was focusing on the wrong set of risks (either too much on the short-term, or too much on the long term).

한 저명한 동료가 나에게 "이 [FLI] 편지가 임박한 AGI, 초지능 등에 대한 부당한 두려움을 불러일으키지 않을까요?"라고 묻는 편지를 보냈습니다. 어떤 사람들은 내가 힌튼의 우려를 증폭시키는 것에 너무 놀랐고, 내 자신의 믿음에 대해 추측하는 전체 트위터 스레드가 나타났습니다.One distinguished colleague wrote to me asking “won’t this [FLI] letter create unjustified fears of imminent AGI, superintelligence, etc?” Some people were so surprised by my amplifying Hinton’s concerns that a whole Twitter thread popped up speculating about my own beliefs:

내 믿음은 사실 변하지 않았습니다. 나는 아직도 대규모 언어 모델이 초지능이나 인공 일반 지능(AGI)과 큰 관련이 있다고 생각하지 않습니다. 나는 여전히 Yann LeCun과 마찬가지로 LLM이 AGI로 가는 길의 "출구"라고 생각합니다. 그리고 파멸에 대한 나의 시나리오는 아마도 Hinton이나 Musk의 시나리오와 같지 않을 것입니다. (내가 말할 수 있는 바에 따르면) 그들의 문제는 주로 컴퓨터가 신속하고 근본적으로 스스로 개선할 경우 어떤 일이 발생하는지에 초점을 맞춘 것 같지만, 나는 이것이 즉각적인 가능성이라고 보지 않습니다.My beliefs have not in fact changed. I still don’t think large language models have much to do with superintelligence or artificial general intelligence [AGI]; I still think, with Yann LeCun, that LLMs are an “off-ramp” on the road to AGI. And my scenarios for doom are perhaps not the same as Hinton’s or Musk’s; theirs (from what I can tell) seem to center mainly around what happens if computers rapidly and radically self-improve themselves, which I don’t see as an immediate possibility.

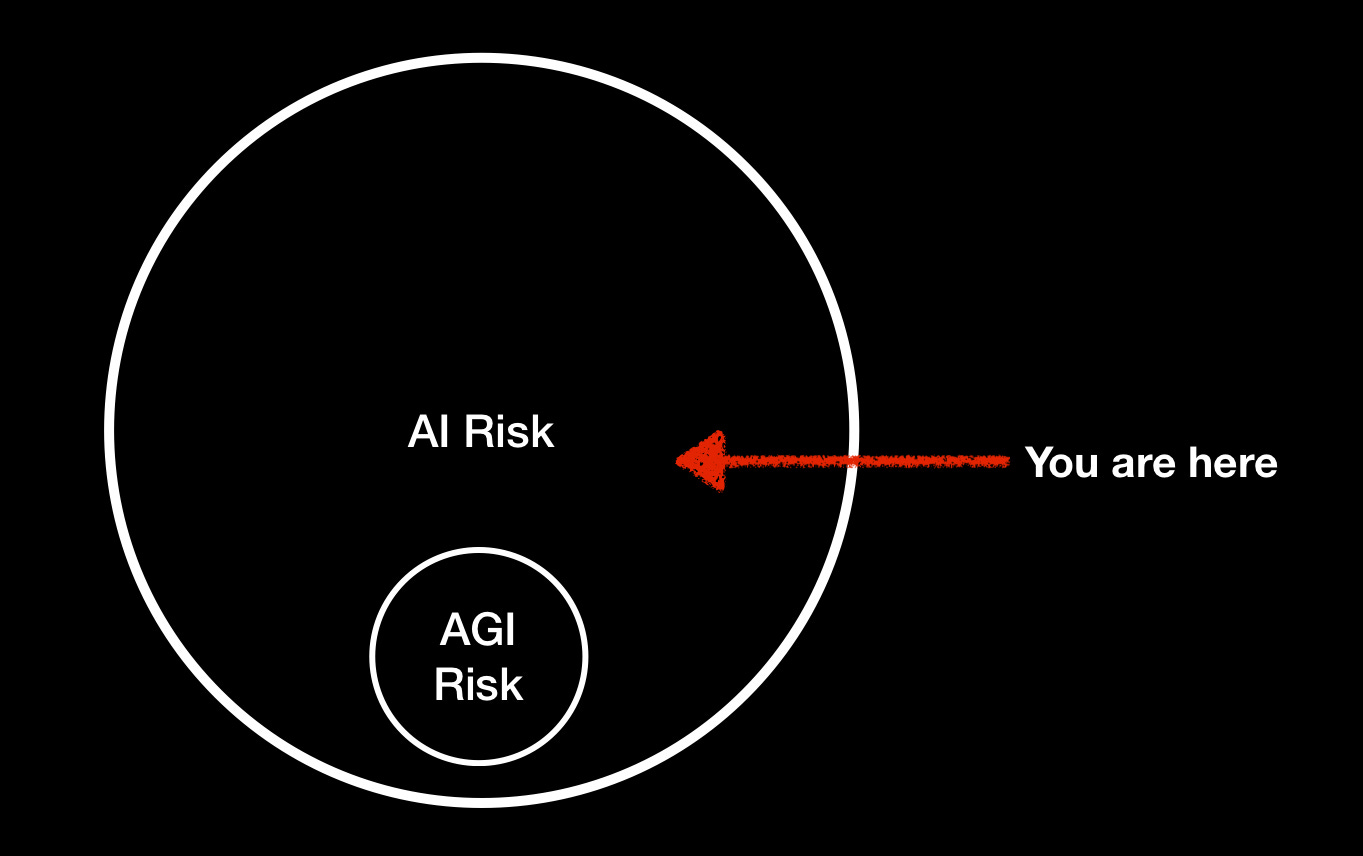

하지만 문제는 이렇습니다. 많은 문헌에서 인공 지능의 위험을 초지능 또는 인공 일반 지능의 위험과 동일시하지만, But here’s the thing: although a lot of the literature equates artificial intelligence risk with the risk of superintelligence or artificial general intelligence, 심각한 문제를 일으키기 위해 초지능이 될 필요는 없습니다 you don’t have to be superintelligent to create serious problems. 나는 "AGI 위험"(우리가 통제할 수 없는 초지능 기계의 위험)에 대해 즉시 걱정하지 않지만, 가까운 시일 내에 "MAI 위험"이라고 부르는 신뢰할 수 없는 평범한 AI(Bing 및 GPT-4)이지만 이를 사용하는 사람의 수와 . I am not worried, immediately, about “AGI risk” (the risk of superintelligent machines beyond our control), in the near term I am worried about what I will call “MAI risk”—Mediocre AI that is unreliable (a la Bing and GPT-4) but widely deployed—both in terms of the sheer number of people using it, and in terms of the 소프트웨어가 전 세계에 접근 할 수 access있다는 측면에서 널리 배포되었습니다 . Adept.AI 라는 회사는 that the software has to the world. A company called 대규모 언어 모델이 거의 모든 것에 액세스할 수 있도록 하기 위해 3억 5천만 달러를 모금했습니다. Adept.AI just raised $350 million dollars to do just that환각과 불안정성에 대한 분명한 경향)., to allow large language models to access, well, pretty much everything (aiming to “supercharge your capabilities on any software tool or API in the world” with LLMs, despite their clear tendencies towards hallucination and unreliability).

아마도 평균 이상의 지능을 갖고 있지만 반드시 천재 수준은 아닐 수도 있는 많은 평범한 인간들이 역사 전반에 걸쳐 온갖 종류의 문제를 만들어냈습니다. 여러 면에서 중요한 변수는 지능이 아니라 Lots of ordinary humans, perhaps of above average intelligence but not necessarily genius-level, have created all kinds of problems throughout history; in many ways, the critical variable is not intelligence but 종종 액세스로 캐시되는 전력입니다 . power, 원칙적으로, 핵 코드를 가진 한 명의 바보가 단지 적당한 양의 정보와 과도한 접근 권한만으로 세계를 파괴할 수 있습니다.which often caches out as access. In principle, a single idiot with the nuclear codes could destroy the world, with only a modest amount of intelligence and a surplus of ill-deserved access.

If OpenAI가 최근 관찰한 것처럼 LLM이 한 사람을 속여 Captcha를 수행하도록 할 수 an LLM can trick a single human into doing a Captcha있다면 악의적인 행위자의 손에서 온갖 종류의 혼란을 일으킬 수 있습니다. LLM이 현장 내에서만 알려진 연구실 호기심이었을 때는 큰 문제가 되지 않았습니다. 그러나 이제 (a) 그들은 널리 알려져 있고 범죄자들의 관심을 끌고 있으며 (b) 외부 세계(인간 포함)에 대한 접근이 점점 더 많이 허용되고 있으므로 더 많은 피해를 입힐 수 있습니다., as OpenAI recently observed, it can, in the hands of a bad actor, create all kinds of mayhem. When LLMs were a lab curiosity, known only within the field, they didn’t pose much problem. But now that (a) they are widely known, and of interest to criminals, and (b) increasingly being given access to the external world (including humans), they can do more damage.

AI 커뮤니티는 종종 장기적인 위험에 초점을 맞추지만, 심각하고 즉각적인 영향에 대해 걱정하는 것은 나 혼자만이 아닙니다. 유로폴은 어제 몇 가지 범죄 가능성을 고려한 보고서를 발표했는데, 이는 경각심을 불러일으킵니다.Although the AI community often focuses on long-term risk, I am not alone in worrying about serious, immediate implications. Europol came out yesterday with a report considering some of the criminal possibilities, and it’s sobering.

그들은 내가 자주 그랬듯이 잘못된 정보를 강조하며 그 외에도 훨씬 더 많은 내용을 강조합니다.They emphasize misinformation, as I often have, and a whole lot more:

✔️ 자세히 알아보기 URL (More information) ↓https://twitter.com/garymarcus/status/1640506504402071552?s=61&t=2voLMkhJf6P349CqztWSAQ

다음은 사기와 테러에 관해 그들이 말한 내용을 발췌한 것입니다.Here’s an excerpt of what they said about fraud and terrorism:

LLM의 도움으로 이러한 유형의 피싱 및 온라인 사기는 더 빠르고, 훨씬 더 확실하고, 규모가 크게 증가할 수 있습니다.With the help of LLMs, these types of phishing and online fraud can be created faster, much more authentically, and at significantly increased scale.

언어 패턴을 감지하고 재현하는 LLM의 기능은 피싱 및 온라인 사기를 촉진할 뿐만 아니라 일반적으로 특정 개인이나 그룹의 언어 스타일을 가장하는 데 사용될 수도 있습니다. 이 기능은 잠재적인 피해자가 범죄 행위자의 손에 신뢰를 두도록 오해하기 위해 대규모로 남용될 수 있습니다.The ability of LLMs to detect and re-produce language patterns does not only facilitate phishing and online fraud, but can also generally be used to impersonate the style of speech of specific individuals or groups. This capability can be abused at scale to mislead potential victims into placing their trust in the hands of criminal actors.

위에서 설명한 범죄 활동 외에도 ChatGPT의 기능은 테러, 선전, 허위 정보 분야에서 여러 가지 잠재적 남용 사례에 적합합니다. 따라서 이 모델은 일반적으로 테러 자금 조달이나 익명 파일 공유와 같은 테러 활동을 촉진할 수 있는 더 많은 정보를 수집하는 데 사용될 수 있습니다.In addition to the criminal activities outlined above, the capabilities of ChatGPT lend themselves to a number of potential abuse cases in the area of terrorism, propaganda, and disinformation. As such, the model can be used to generally gather more information that may facilitate terrorist activities, such as for instance, terrorism financing or anonymous file sharing.

아마도 AI가 생성한 대규모 선전과 결합하여 LLM으로 강화된 테러리즘은 결국 핵전쟁이나 코로나19보다 더 나쁜 병원체의 고의적 확산 등으로 이어질 수 있습니다. 수많은 사람이 죽을 수 있습니다. 문명이 완전히 붕괴될 수도 있다. 어쩌면 인간이 문자 그대로 “땅에서 멸망”되지는 않을지 모르지만 상황은 실제로 매우 나빠질 수 있습니다.Perhaps coupled with mass AI-generated propaganda, LLM-enhanced terrorism could in turn lead to nuclear war, or to the deliberate spread of pathogens worse than covid-19, etc. Many, many people could die; civilization could be utterly disrupted. Maybe humans would not literally be “wiped from the earth,” but things could get very bad indeed.

이런 가능성은 얼마나 되나요? 우리는 세상적인 생각이 없습니다. 제가 트윗에 올린 1% 수치는 단지 사고 실험에 불과했습니다. 하지만 0%는 아닙니다.How likely is any of this? We have no earthly idea. My 1% number in the tweet was just a thought experiment. But it’s not 0%.

"상상할 수 없는 일이 아니다"라는 Hinton의 말은 정확히 맞았으며, 내 생각에는 Eliezer Yudkowsky와 같은 사람들이 걱정했던 일부 장기 시나리오와 Europol과 내가 걱정했던 일부 단기 시나리오 모두에 적용되는 것 같습니다. 에 대한.Hinton’s phrase — “it’s not inconceivable” — was exactly right, and I think it applies both to some of the long-term scenarios that people like Eliezer Yudkowsky have worried about, and some of the short-term scenarios that Europol and I have worried about.

§§

진짜 문제는 The real issue is 통제다 control. 위의 트윗에 링크한 기사(자체는 . Hinton’s worry, as articulated in the article I linked in my tweet above (itself a summary of CBS 인터뷰 요약 a CBS interview)에 명시되어 있듯이 Hinton의 걱정은 우리가 자기 개선 기계에 대한 통제력을 잃으면 어떤 일이 발생하는지에 관한 것이었습니다. 언제 우리가 그런 기계를 갖게 될지는 모르겠지만, 현재 AI에 대한 제어권이 많지 않다는 것은 알고 있습니다. 특히 사람들이 AI를 TaskRabbit 및 실제 소프트웨어 API에 연결할 수 있기 때문에 더욱 그렇습니다.) was about what happens if we lose control of self-improving machines. I don’t know when we will get to such machines, but I do know that we don’t have tons of controls over current AI, especially now that people can hook them up to TaskRabbit and real-world software APIs.

우리는 스카이넷과 로봇이 세계를 장악하는 것에 대한 걱정을 멈추고 테러리스트를 포함한 범죄자들이 LLM을 사용하여 무엇을 할 수 있는지, 그리고 그들을 막기 위해 무엇을 할 수 있는지에 대해 더 많이 생각해야 합니다. We need to stop worrying (just) about Skynet and robots taking over the world, and think a lot more about what criminals, including terrorists, might do with LLMs, and what, if anything, we might do to stop them.

그러나 우리는 But we 또한 alsoLLM을 미래 합성 지능의 드레스 리허설로 취급하고 제어하기가 훨씬 더 어려울 수 있는 미래 기술로 도대체 무엇을 할 것인지에 대해 스스로에게 어려운 질문을 던져야 합니다. Hinton은 CBS와의 인터뷰에서 "내 생각에 사람들이 이러한 문제에 대해 지금 걱정하는 것은 매우 합리적이라고 생각합니다. 비록 내년이나 2년 안에는 그런 일이 일어나지 않을지라도"라고 저도 동의합니다. need to treat LLMs as a dress rehearsal future synthetic intelligence, and ask ourselves hard questions about what on earth we are going to do with future technology, which might well be even more difficult to control. Hinton told CBS, “I think it's very reasonable for people to be worrying about these issues now, even though it's not going to happen in the next year or two”, and I agree.

그것은 둘 중 하나의 상황이 아닙니다. 현재 기술은 이미 It’s not an either/or situation; current technology already poses 우리가 준비하지 못한 엄청난 위험을 안고 있습니다. enormous미래 기술로 인해 상황은 더욱 악화될 수 있습니다. 사람들이 "잘못된 위험"(트위터에서 항상 인기 있는 스포츠)에 집중한다고 비판하는 것은 누구에게도 도움이 되지 않습니다. 돌아다닐 위험이 충분히 있어요. risks that we are ill-prepared for. With future technology, things could well get worse. Criticizing people for focusing on the “wrong risks” (an ever popular sport on Twitter) isn’t helping anybody; there’s enough risk to go around.

우리는 모두의 손이 필요합니다.We need all hands on deck.